Nuestros proyectos

Kefuri es un sistema de aviso automático de presencia de posible donante de órganos desde el personal de Urgencia hacia la Unidad de Procuramiento y UCI.

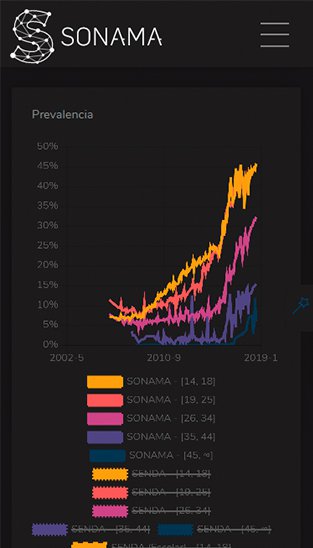

Plataforma informática de análisis de redes sociales para estudiar la prevalencia de la marihuana y alcohol en Chile.

Ruta Digital es un programa de Sercotec que busca entregar herramientas a las micro y pequeñas empresas, facilitando la incorporación y uso de tecnología en la gestión de sus negocios.

El Sistema de Análisis de Bolsas de Empleo (SABE) un proyecto que recopila y estandariza información procedente de varios portales de búsqueda en internet en Chile. Utilizando técnicas de minería de textos y aprendizaje automático (machine learning), clasifica los avisos de trabajo y las descripciones de último empleo de los postulantes en categorías ocupacionales. Además en el mediano plazo detectará habilidades descritas en avisos de empleo, y clasificará los avisos por sector económico, ubicación geográfica y requerimiento educacionales de los postulantes.